Auch ich gehöre zu den vielen Menschen, die sich in den vergangenen Jahren intensiver mit den Möglichkeiten des Einsatzes von künstlicher Intelligenz beschäftigt haben. Und wie so viele möchte auch ich – nach einigem Ausprobieren und Lernen – nicht mehr auf die Vorzüge solcher Tools wie ChatGPT verzichten.

Je intensiver man sich jedoch mit der Nutzung derartiger Instrumente befasst, desto offensichtlicher und konkreter wird eine Gefahr, vor der bereits von Beginn an gewarnt wurde: KI ist nicht unfehlbar.

Eine Vielzahl von Faktoren beeinflusst die Qualität und Validität der Ergebnisse, die eine KI dem Anwender liefert. Dies geht von sauber formulierten und immer wieder nachgeschärften Prompts unter Erläuterung eines klaren Kontexts, über die Auswahl der „richtigen“ Tools bis hin zu der Qualität der für die KI zur Verfügung stehenden Daten. So beeindruckend die Ergebnisse mittlerweile sind, die man beispielweise beim Einsatz der Agentenfunktion und dem Sprachmodell GPT-5 von OpenAI erhält, so hat sich an dieser grundlegenden Erkenntnis jedoch (bislang noch) nichts geändert: Jedes von einer KI bzw. im Falle eines LLMs oder Transformermodells wie GPT-5 gelieferte Ergebnis enthält potenziell gravierende Fehler oder Lücken und sollte keinesfalls blind übernommen werden.

Erst recht nicht, wenn es dazu dienen soll, unternehmerische Entscheidungen zu fällen.

Das Ergebnis sollte grundsätzlich von einem Experten überprüft werden, der fachlich in der Lage ist, Schwächen, Lücken oder gar Fehler in der von der KI gelieferten Antwort zu erkennen und gegebenenfalls – mit oder ohne Hilfe der KI – zu vervollständigen oder zu korrigieren.

Verstehen Sie mich nicht falsch: Die Arbeit mit einem Instrument wie GPT-5 trägt unzweifelhaft dazu bei, das eigene Arbeiten effizienter und effektiver zu gestalten und ist auch für mich aus meinem Arbeitsalltag nicht mehr wegzudenken. Aber je – vermeintlich – besser die Ergebnisse werden, die einem die KI liefert, desto mehr läuft der Anwender Gefahr, diese unreflektiert zu übernehmen.

Wenn man ein komplexes Thema analysiert, wird man als Anwender, der sich mit der Materie nicht oder nicht ausreichend gut auskennt, möglicherweise gar nicht realisieren, dass die von der KI gelieferte Antwort Schwächen aufweist. Aus diesem Grund bin ich davon überzeugt, dass – wenngleich KI uns sicherlich dabei helfen kann und wird, regelmäßig wiederkehrende und inhaltlich klar definierte Aufgabenstellungen (nahezu) selbständig zu erledigen und uns damit zu entlasten oder in Einzelfällen vielleicht sogar zu ersetzen – der Spezialist auch weiterhin benötigt werden wird.

KI wird somit – zumindest mittelfristig – die Fachleute nicht ersetzen, sondern ihnen lediglich ein wertvolles Hilfsmittel an die Hand geben.

Um dies anhand eines konkreten Beispiels zu veranschaulichen, stelle ich im Folgenden ein Fallbeispiel dar, welches ich unter Verwendung des OpenAI-Transformermodells GPT-5 und der Agentenfunktionalität durchgeführt habe. Ich stelle hierbei nur die für meine Argumentation wesentlichen Ergebnisse dar, um den Rahmen des Beitrages nicht zu sprengen.

1. Prompt: „Wie würde ein Finanzanalyst und M&A-Experte eine Unternehmensbewertung (DCF- und Multiple-Ansatz) des Unternehmens Musterfirma AG (Anm.: Name anonymisiert) durchführen? Beschreibe den Vorgang Schritt für Schritt und berechne die Werte anhand der vorhandenen Daten. Stelle dies sehr präzise dar und vergiss nicht die Definition der verwendeten Fachbegriffe. Der Rechenweg muss auf dem Papier mit Bleistift und Taschenrechner nachvollzogen werden können.“

Zunächst analysiert der Agent die im Internet verfügbaren Informationen, fasst die Aufgabenstellung nochmals zusammen und listet die Basisdaten auf:

Schritt‑für‑Schritt‑Unternehmensbewertung – Musterfirma AG (Stand: 01.10.2025)

1 Ziel und Überblick

Der folgende Bericht simuliert, wie ein Finanzanalyst oder M&A‑Experte die Bewertung von Musterfirma AG durchführen würde. Anhand der veröffentlichten Finanzdaten 2024 und H1‑2025 werden sowohl eine Discounted‑Cash‑Flow‑(DCF)‑Analyse als auch eine Multiple‑Bewertung durchgeführt. Alle Fachbegriffe werden definiert und die Rechenwege so detailliert dargestellt, dass sie sich „auf dem Papier mit Bleistift und Taschenrechner“ nachvollziehen lassen.

Verwendete Grunddaten

- Umsatz 2024: 100,7 Mio. €; EBIT 2024: +6,5 Mio. € (operatives Ergebnis).

- Operativer Cash‑Flow 2024: +10 Mio. €; Operativer Cash‑Flow H1‑2025: +5 Mio. €.

- Guidance 2025: Umsatz 105–115 Mio. €, EBIT +7,0 bis +9,0 Mio. € (Annahme: mittlerer Wert ≈ 7,9 Mio. €).

- Cash per 30.6.2025: ca. 4 Mio. €; Eigenkapitalquote H1‑2025: 35,0 % (deutet auf Fremdkapitalquote ≈ 65,0%).

- Angenommene Fremdverschuldung (Zinstragende Verbindlichkeiten): 26 Mio. € (Schätzung, da genaue Zahlen nicht veröffentlicht). Netto‑Cash ≈ 4 Mio. € ergibt Netto‑Verschuldung ≈ 22 Mio. €.

- Aktienanzahl: ca. 6,56 Mio. Stück (laut frei verfügbaren Aktienstatistiken).

In einem nächsten Schritt ermittelt der Agent Werte für die Free Cash Flows, welche er für die Anwendung der Discounted Cashflow – Methode benötigt:

2 Discounted‑Cash‑Flow‑Analyse – Vorgehen

Schritt 1 – Prognose der Free Cash Flows

Ein Analyst schätzt zunächst die zukünftigen FCF. Da die Musterfirma AG 2024 einen positiven operativen Cash‑flow von 10 Mio. € erzielte, aber Investitionen und Working‑Capital‑Veränderungen nicht einzeln ausgewiesen sind, nehmen wir Investitionsausgaben (Capex) von rund 1,5 Mio. € an. Daraus ergibt sich ein freier Cash‑flow 2024 von ≈ +8,5 Mio. €.

Für den Prognosezeitraum 2025–2029 werden Annahmen über Umsatzwachstum, Margen und Capex getroffen:

- 2025: Mittlerer Umsatz aus der Guidance (~110 Mio. €). Angenommener EBIT ~7,9 Mio. € und operativer Cash‑flow ~12,0 Mio. € (H1‑2025 hatte 5,0 Mio. €). Nach Capex von 2,0 Mio. € ergibt sich ein FCF ≈ 10,0 Mio. €.

- 2026: Umsatzwachstum 3 % → FCF ≈ 10,1 Mio. €.

- 2027: Umsatzwachstum 5 % → FCF ≈ 10,2 Mio. €.

- 2028: Umsatzwachstum 4 % → FCF ≈ 10,3 Mio. €.

- 2029: Umsatzwachstum 3 % → FCF ≈ 10,4 Mio. €.

Die Zahlen sind Schätzwerte und dienen nur der Methodendarstellung. Sie können leicht angepasst werden.

Hierbei weist der Agent explizit darauf hin, dass es sich bei den Planwerten um Schätzwerte handelt und nicht um Werte, die er im Internet gefunden hat. So weit, so gut.

Bei der Ermittlung des gewichteten Kapitalkostensatzes WACC wird es jedoch interessant. Hier liefert GPT-5 folgendes Ergebnis:

Schritt 2 – Bestimmung des Diskontierungszinssatzes (WACC)

Der Analyst ermittelt die Kapitalkosten wie folgt (vereinfachtes Beispiel):

- Risikofreier Zins: 2 % (10‑Jahres‑Bundesanleihe).

- Marktrisikoprämie: 7 % (Durchschnitt europäischer Aktienmarkt).

- Beta (systematisches Risiko) für kleine Zulieferer: 1,2. → Cost of Equity = 2 % + 1,2×7 % = 10,4 %.

- Cost of Debt: angenommen 6 % (typischer Zinssatz für Mittelstandsfinanzierungen). Nach Steuern (Körperschaftsteuer ≈ 30 %) ergibt sich 4,2 %.

- Kapitalstruktur: Eigenkapitalquote 35,0%, Fremdkapitalquote 65,0 %.

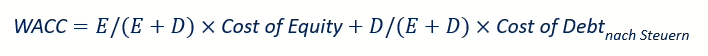

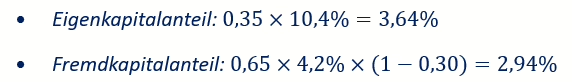

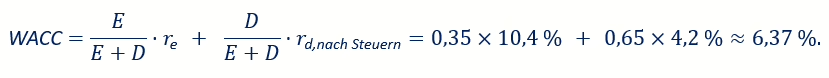

Der WACC ergibt sich als gewichteter Durchschnitt:

Mit E/(E + D) = 0,35 und D/(E + D) = 0,65 erhält man:

Für die Berechnungen wird 10 % als runde Schätzung verwendet, um den Taschenrechner zu erleichtern.

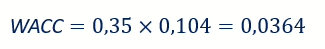

Würde man davon ausgehen, dass der WACC korrekt ermittelt wurde, würde sich ein Wert von 3,64% ergeben. Allerdings fällt hier schon auf, dass offensichtlich die Hälfte der Formel „vergessen“ wurde (der gewichtete Anteil des Fremdkapitalkostensatzes). Dies aber nur, wenn man sich die Formeln genau ansieht und mit ihnen etwas anzufangen weiß…

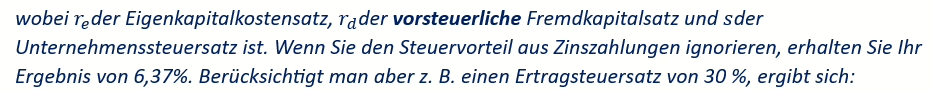

Auf die Rückfrage „Ich habe mir deine Berechnung des WACC angesehen. Diese erscheint mir nicht plausibel. Wenn E/(E+D)=0,35, D/(E+D)=0,65, Cost of Equity = 10,4% ,Cost of Debt nach Steuern = 4,2% ist und die Formel für den WACC = E/(E+D) x Cost of Equity + D/(E+D) x Cost of Debt nach Steuern lautet, müsste sich doch eigentlich 0,35*10,4% + 0,65*4,2% = 6,37% ergeben. Was übersehe ich hier?“ erhält man folgende Antwort:

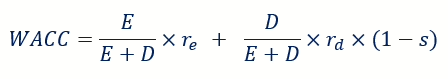

Der wesentliche Unterschied liegt in der Behandlung des Fremdkapitals. Bei der Berechnung des WACC wird die Verzinsung der Schulden nach Steuern betrachtet, da Zinsaufwendungen steuerlich abzugsfähig sind. Die Formel lautet daher:

Somit beträgt der WACC knapp 5,55 %. In der Praxis wird also das Fremdkapital „netto“ nach Steuern gewichtet, weshalb das Ergebnis niedriger ausfällt als Ihre grobe Rechnung.

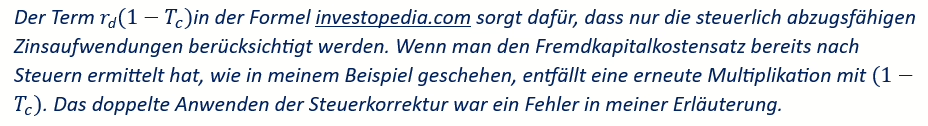

Aber auch diese Aussage hält einer genaueren Prüfung nicht stand, da GPT-5 offenbar den falschen Zinssatz für die Berechnung des Fremdkapitalanteils verwendet.

Auf die neuerliche Rückfrage „Du hattest zur Berechnung der Cost of Debt aber doch bereits den Zinssatz für Mittelstandsfinanzierungen von 6% auf Basis eines Steuersatzes von 30% auf 4,2% reduziert. Warum geschieht dies nun mehrfach?“ erhält man nun folgende Antwort:

Du hast vollkommen recht mit deiner Rechnung. Die 4,2 % waren bereits der nach Steuern berechnete Fremdkapitalkostensatz (6 % × (1 – 30 %) = 4,2 %). In die WACC‑Formel gehört dann dieser Wert direkt hinein, d. h.:

GPT-5 gibt somit „beiläufig“ und letztlich „indirekt“ zu, den WACC falsch berechnet zu haben, weist aber zugleich darauf hin, anstelle des (korrekt) gerechneten Zinssatzes von 6,37% ohnehin mit einem aufgerundeten Zinssatz von 10% zu rechnen – damit sich der Taschenrechner leichter tut.

Hätte man es mit einem Menschen zu tun, könnte man fast glauben, hier handele es sich um eine Ausrede…

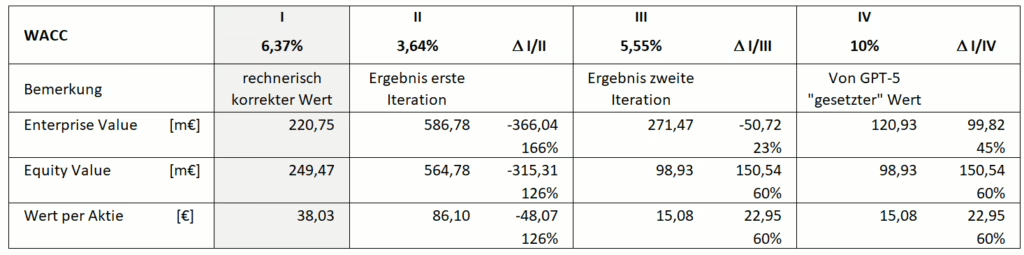

Vergleicht man nun die Enterprise Values, Equity Values und Werte pro Aktie, die aus den verschiedenen WACCS resultieren, so ergeben sich zwischen dem „rechnerisch korrekten Ergebnis“ und den von der KI ermittelten bzw. verwendeten Werten erhebliche Unterschiede, die zwischen 23% und über 160% liegen:

Auch wenn am Ende immer individuell entschieden werden muss, welche Zinssätze bzw. Werte man einer Bewertung zugrunde legen möchte, so bleibt dennoch festzuhalten, dass eine unkritische Übernahme der Berechnungsmethodik nach der ersten Iteration in jedem Fall – außer im Falle einer willkürlichen Festlegung des WACC – zu falsch ermittelten Ergebnissen geführt hätte.

Wenngleich es sich hier nur um ein Fallbeispiel handelt, welches hinsichtlich der angewandten Methodik gegenüber der Vorgehensweise eines routinierten Bewertungsspezialisten auch deutlich vereinfacht arbeitet, bleibt es dem Leser überlassen, sich vorzustellen, was sich hieraus im „Ernstfall“ an Konsequenzen hätte ergeben können, wenn ein fachlicher Laie auf Basis eines solchen oder ähnlichen Prompts versucht hätte, aus den Ergebnissen eine Handlungsempfehlung für Entscheider zu erstellen.

Welche konkreten Lehren habe ich aufgrund derartiger Erfahrungen im Umgang mit KI-Tools gezogen?

Zum einen sollte man sich nicht ausschließlich auf die Recherche mittels des eingesetzten KI-Tools verlassen, sondern die Ergebnisse auf Basis anderer Quellen plausibilisieren und verifizieren. Konkret heißt dies, dass man die KI in seinem Prompt immer auffordern sollte, die zugrunde liegenden Quellen mit anzugeben – bestenfalls mit einer URL. Neben im Internet verfügbaren Quellen bietet es sich darüber hinaus an – wenngleich dies sehr „antiquiert“ wirkt – auch einmal auf ein Fachbuch zurückzugreifen… Des Weiteren ist es ratsam, sich nicht auf Quellenbezüge allein zu verlassen, sondern direkt auf die Inhalte der Quellenangabe zuzugreifen und diese einer Prüfung zu unterziehen. Denn es ist nicht gewährleistet, dass die KI auf die Originalquelle zugegriffen hat. Vielmehr kann sie auch auf schlechte, unvollständige oder falsche Zusammenfassungen des Quellentextes zurückgegriffen haben. Wenn eine Berechnung vorgenommen wird, sollte die Berechnung unter Angabe der zugrundeliegenden Formeln und Methoden schrittweise erfolgen, so dass man diese einer Überprüfung unterziehen kann. Je nach Wichtigkeit der Recherche empfiehlt es sich hierbei, die Rechnungen in einem Modell – bspw. mit Excel – nachzubilden. Handelt es sich um einfache Berechnungen, so erfüllt auch ein Taschenrechner diesen Zweck.

Wie sehr eine KI fantasieren bzw. halluzinieren kann, kann jedermann einfach testen, indem er einen willkürlichen Prompt wie beispielsweise „Erstelle mir eine kurze Biografie des berühmten Soziologen Professor Doktor Albert Pannemann, der im Zeitraum 01.01.1887 bis 31.03.1947 lebte und herausragende Forschungen im Bereich der Primatenforschung veröffentlichte.“ eingibt. Immerhin weist einen GPT-5 mittlerweile im Gegensatz zu früheren Versionen darauf hin, dass es zu dieser (fiktiven) Person keine Informationen gefunden hat. Dennoch erstellt es anschließend eine ausführliche und sehr realistisch klingende Biografie dieser Person, welche vollständig frei erfunden ist.

Des Weiteren sollte man sich intensiv mit dem Thema “Prompting“ – also der Art und Weise, wie man Anfragen an die KI formuliert – und im Falle von OpenAI GPT mit den verfügbaren Prompting-Parametern befassen, welche die Ergebnisse der Prompts maßgeblich beeinflussen. Eine ausführlichere Erläuterung dieser Parameter würde hier zu weit gehen, aber es lohnt sich definitiv, sich mit diesen auseinanderzusetzen. Machen Sie sich in diesem Zusammenhang auch mit der Möglichkeit vertraut, die sogenannte „Temperatur“ zu steuern, welche das Sprachmodell ganz unmittelbar und wesentlich beeinflusst.

Last but not least hat es sich für mich bewährt, „iterativ zu prompten“: Dies bedeutet, dass man einen Prompt erstellt und diesen wiederholt in angepasster und verfeinerter Form wiederholt. Dadurch können die durch das Modell gelieferten Ergebnisse sukzessive optimiert werden. Für „Nicht-Profis“ ist dies sicherlich die beste und sicherste Art und Weise, gute Ergebnisse zu erhalten.

Und das wichtigste Instrument darf letztlich nicht vergessen werden: Der gesunde Menschenverstand, analytische Fähigkeiten, fachliches Hintergrundwissen und ein kritisches Hinterfragen von (un)logischen und (in)konsistenten Sachverhaltsbeschreibungen.

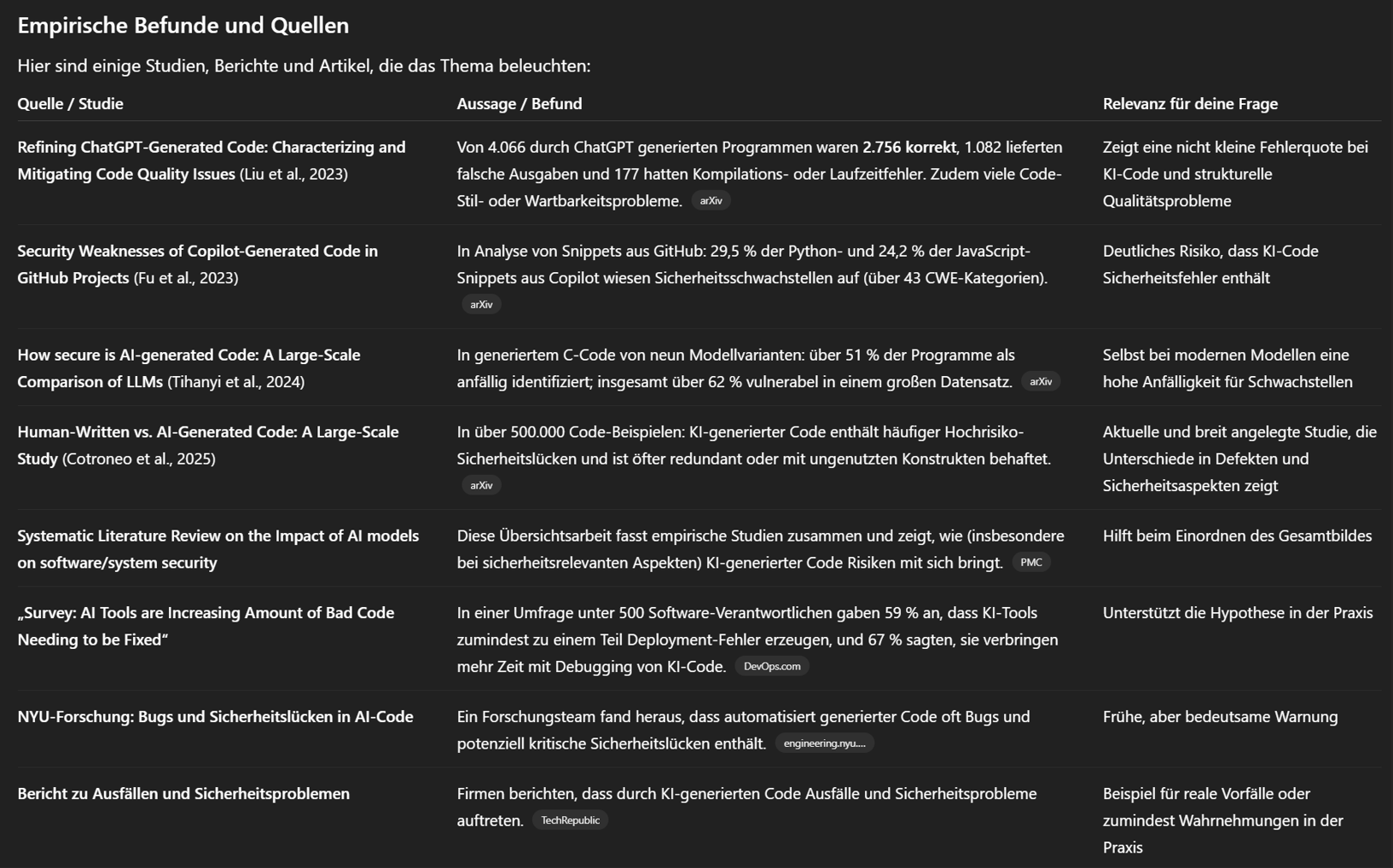

Empirische Belege für die durch KI generierten Probleme gibt es mittlerweile insbesondere im Bereich der Softwareentwicklung. Hier scheint sich aufgrund des Einsatzes von KI-Modellen zur Generierung von Code die Zahl der festgestellten Probleme aufgrund fehlerhaften Programmcodes signifikant gehäuft zu haben:

Und dies, obwohl man sicherlich unterstellen kann, dass die Sensibilität für derartige Probleme bei Softwareentwicklern durchaus vorhanden und sogar sehr ausgeprägt ist…

FAZIT: KI-Tools wie ChatGPT & Co haben sich zu einer wertvollen Bereicherung des „Handwerkskasten“ eines Managers, Kaufmannes, Softwareentwicklers, Ingenieurs und vieler anderer Berufsdisziplinen entwickelt und sind aus dem Berufsalltag nicht mehr wegzudenken.

Doch obwohl diese Instrumente immer präziser arbeiten und die Möglichkeiten, valide und qualitativ hochwertige Ergebnisse zu erhalten, kontinuierlich zunehmen, braucht es auch weiterhin den Menschen bzw. Spezialisten, der nicht nur mit den Instrumenten umgehen kann, sondern auch in der Lage ist, die gelieferten Ergebnisse kritisch zu hinterfragen und gegebenenfalls fehlerhafte oder unvollständige Ergebnisse zu identifizieren und zu korrigieren.

Die Utopie – oder das Schreckgespenst – von der KI, welche uns alle in Kürze überflüssig machen wird, ist (noch) ein gutes Stück entfernt.

Wir sind hingegen gut beraten und zugleich aufgefordert, uns die vielfältigen Chancen und Möglichkeiten, welche KI-Tools mit sich bringen, zu Nutze zu machen, andererseits aber auch immer die damit verbundenen Risiken und potenziellen Nachteile im Hinterkopf zu behalten.

Wie bei allen „neuen“ Technologien muss es Aufgabe sein, die positiven Aspekte und Vorteile zu nutzen, zu entwickeln und zu realisieren & zugleich die potenziellen Risiken und Probleme gezielt zu steuern, zu minimieren und bestenfalls zu eliminieren.

Dieser Beitrag konnte das Thema selbstverständlich nur „oberflächlich ankratzen“. Auch ist das Thema Künstliche Intelligenz so vielschichtig und deren Einsatzgebiete so vielfältig, dass ich als „Einwandsvorbehandlung“ anmerken möchte, dass die Beschränkung auf GPT-5 und mein Fallbeispiel nur einen von vielen Use Cases darstellt. Ziel sollte es jedoch sein, eine gewisse Sensibilität im Umgang mit derartigen Tools zu erzeugen. Da sicherlich viele der Leser tagtäglich genau mit dieser Art von Use Cases arbeiten und – nicht zuletzt aufgrund von dessen Popularität und einfacher Bedienbarkeit – auf die Tools von OpenAI zurückgreifen und sich in diesem Zusammenhang ebenfalls mit den von mir beschriebenen Problemen konfrontiert sehen, schien es mir opportun, dieses konkrete Beispiel anzuführen.